連想記憶の実装

シャシャタ・ソーミャとハーヴィア・シン著

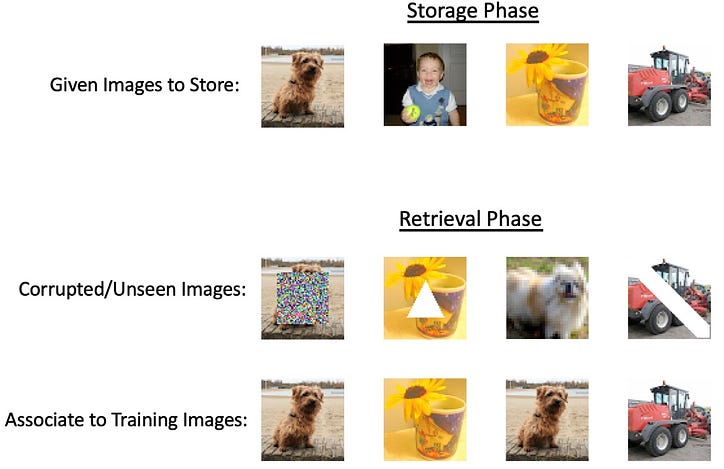

大規模なニューラル ネットワークの出現と、現在の手法を限界まで押し上げる技術の進歩により、あらゆることを実行することを目的とした包括的なツールの作成に焦点が当てられています。ただし、ほとんどのタスクでは、信じられないほど集中的なディープ ネットワークは必要ありませんが、それでも基本的な数学モデルよりも汎用性の高いものが必要です。ディープニューラルネットの強度を必要としない潜在的なタスクは、連想記憶と呼ばれる情報の保存と検索です。ここでの考え方は、何らかの入力が与えられると、それら 2 つを関連付けて「メモリ」に保持するシステムから関連する出力を取得できるようにしたいということです。連想記憶という名前は、私たちの脳が概念を結び付けることができる記憶保存システムであるという心理学的概念に由来しています。連想メモリの 1 つのタイプは自動連想メモリで、必要な出力の部分表現を入力として与えます。これは、ノイズが追加された出力か、マスクされた出力の一部である可能性があります。このタイプの記憶が機能している例としては、親戚の部分的な画像を見て、脳が残りの画像を頭の中で自動的に埋めることができることが挙げられます。もう 1 つのタイプはヘテロ連想記憶で、出力は指定された入力のさまざまなカテゴリに属する可能性がありますが、モデルはそれらを相互にリンクすることを覚えています。「犬」という言葉を聞くと、あなたの脳はそれを「猫」や「リード」などの他の概念と自動的に関連付けることができると想像してください [1]。このタイプの記憶が機能している例としては、親戚の部分的な画像を見て、脳が残りの画像を頭の中で自動的に埋めることができることが挙げられます。もう 1 つのタイプはヘテロ連想記憶で、出力は指定された入力のさまざまなカテゴリに属する可能性がありますが、モデルはそれらを相互にリンクすることを覚えています。「犬」という言葉を聞くと、あなたの脳はそれを「猫」や「リード」などの他の概念と自動的に関連付けることができると想像してください [1]。このタイプの記憶が機能している例としては、親戚の部分的な画像を見て、脳が残りの画像を頭の中で自動的に埋めることができることが挙げられます。もう 1 つのタイプはヘテロ連想記憶で、出力は指定された入力のさまざまなカテゴリに属する可能性がありますが、モデルはそれらを相互にリンクすることを覚えています。「犬」という言葉を聞くと、あなたの脳はそれを「猫」や「リード」などの他の概念と自動的に関連付けることができると想像してください [1]。

AM (連想記憶) システムには豊かな歴史がありますが、技術的な進歩の概要を示す重要な研究マイルストーンがあります。

- Willshaw ネット (Willshaw et al、1969)

- ホップフィールド ネットワーク (ホップフィールド、1982)

ホログラムの「記憶に似た」特性に触発されて、DJ Willshaw は 1969 年にコレログラフ (コレログラム) と連想記憶への定量的アプローチを提案しました。

上の図は、C 上に新しいパターンを作成するためのパターン A と B の畳み込みを示しています。より具体的には、A と B にはピンホールが含まれており、そこから光源 (A の後ろ) が通過して、両方のパターンに関する情報を含むパターンを C 上に作成します。ピンホール。このことから、下の図 2 を参照してください。C に投影されたパターンからピン ホールを作成し、C の背後から B を通過して発光する光によって、A のピンホールが位置する場所とまったく同じパターンが生成されます。

コレログラフの構築中に、Willshaw は、A と B の両方に N 個のピンホールが含まれている場合、C 上のパターンのサイズは N² になることに気づきました。これは、N 個の平行線 (A を表す) と N 個の平行線 (B を表す) の交差点である連想ネットの提案につながりました。

ネットの構築では、左入力と右入力の両方がオンの場合、N² 空間内の各半円がオンになり、相互の関連を表します。次に、左側からオン円をたどり、N² 点のどれが上にあるかを確認することで、上からどのオン円に関連付けられているかを確認することで、B からパターン A を取得できます。これが 1 つのペアの関連付けだけで簡単に機能することは明らかですが、同じネット内で複数のパターンを学習することも可能です。Willshaw は、ネットワークの効率が理論的に最大になるのは、N² ポイントの 50% がオンになったときであることを示しています。これにより、「偽のヒット」の可能性が減少します。これは、もともと B パターンに関連付けられていなかった A 内のポイントを示唆しています [2] ]。

ホップフィールドネットワーク

当然のことながら連想ネットワークに続いて、現代の AM 設計に拍車をかける大きな革新が 1982 年に起こり、ニューラル ネットワークのゴッドファーザーと呼ばれることが多いジョン ホップフィールドがホップフィールド ネットワークを提案しました。ネットワークは、各ニューロンがバイナリ状態 (0 または 1) にあるリカレント完全接続であり、入力値と必要な出力値の間の指定された重みが重み行列で表されます。

Tij が対応する重み行列の場合、関連付けは次のように行われます。

ここで、カットオフ量の U は、精度を向上させるために賢く選択されています。

複数の関連付け状態を保存するには、次のアルゴリズムが提供されます。

i=j の場合、T の重みは 0 であるという制限を課します。これにより、次の擬似直交性が得られます。

これは、Vi が 1 の場合、J の予測値は正であり、0 の場合、負であることを示唆しています。これは、U が 0 である前述の相関ルールに従います。

この学習アルゴリズムは基本的に各パターンの安定状態を平均化しますが、これにより、特定のネットワークが記憶できるパターンの数に負担がかかります。Hopfield は、イジング モデルとエネルギー最小化に触発されて、この更新メカニズムをエネルギー最小化として解釈することを提案しています。N ノードのリカレント ネットワークの場合、すべてのノードが互いに接続されており、一度に 1 つのランダムなノードを取得し、重み行列を使用してそのノードを更新します。

ここで、s はノード番号、括弧内の値はタイムステップです。

安定点を研究する際、更新アルゴリズムは次のエネルギー規則によって定義されます。

これは、Vi の変化 (+ または -) が行列乗算からの出力の符号と一致する限り、Vi へのあらゆる変化がネットワークのエネルギーを減少させることを示唆しています。

ノードは、指定されたエネルギー ルールとしきい値に従って非同期かつランダムに更新されます。更新ルールは各タイム ステップでエネルギーを減少させる場合にのみニューロンを変更するため、安定したエネルギー状態に到達することが保証されます。存在できる安定状態の数を決定するとき、モデル内の N 個のニューロンに対して約 0.15N 個の状態が存在することが示され、厳密に o(N) スケーリング [3]。また、このタイプのネットワークの構造は自動連想タスクの成功に役立ちますが、ヘテロ連想メモリも実装できる「ベクトル-行列-ベクトル」エンコーディングなどのバリエーションも存在することに注意することも重要です[4]。

生物学的理論

上記のすべてのモデルを推進する重要なアイデアは、ニューロンが一致するパターン内のニューロンと一致する場合に接続を促進することです。この学習スタイルは「ヘビアン学習」として知られており、2 つのニューロンが同時に発火するとシナプスの接続が促進されます。脳内での記憶形成はまだ未知の現象ですが、この「一緒に火を付ける」という考えは生物学的に正確であることが研究室で示されています[5]。

連想記憶のインシリコ実装

連想メモリは、異なるデータ間の関係または関連付けに基づいて情報の保存と取得を可能にするメモリの一種です。このようなシステムの計算モデルの開発は、神経科学と人工知能の交差点において確立された問題です。ホップフィールド ネットワークのようなよく研究された手法では、バイナリ パターンしか保存できません。ただし、複雑なデータ (画像やテキストなど) の場合、問題を解決するには複雑なシステムが必要です。

エネルギーベースの方法は連想記憶の優れた計算モデルですか?

ほとんどすべてのエネルギーベースの連想記憶モデルは、エネルギー関数の極小値にパターンを保存します。これらのモデルの背後にある主なアイデアは、保存されたパターンが低エネルギーの安定状態に対応するエネルギー状況を定義することです。エネルギー関数は、それぞれが保存されたパターンを表す複数の極小値を持つように設計されています。システムは入力を受け取ると、その状態を繰り返し更新してエネルギー関数を最小化し、最終的に最も近い保存されたパターン (入力に最も近い局所最小値) に収束します。一部のエネルギーベースのモデルは次のとおりです。

ホップフィールド ネットワーク [2]:ホップフィールド ネットワークのエネルギー関数は、ネットワークの状態の二次関数として定義されます。保存された各パターンは、このエネルギー関数の極小値に対応します。ネットワークダイナミクスにより、システムがこれらの極小値の 1 つに確実に収束し、関連するパターンが効果的に取得されます。

ボルツマン マシン [6]:ボルツマン マシンでは、エネルギー関数はノードの状態とノード間の接続の重みによって定義されます。学習プロセスでは重みを調整して、保存されたパターンに対応する極小値を持つエネルギー ランドスケープを作成します。次に、システムは確率力学を使用してエネルギー状況を調査し、極小値に落ち着き、対応するパターンを取得します。

平均場理論に基づくアプローチ [7]:これらのアプローチは、エネルギー関数の極小値のパターンも保存します。複雑なシステムのダイナミクスを平均場理論で近似することにより、学習および検索プロセスをより効率的に分析および最適化できます。

これらの従来のモデルは小規模な画像データを処理できますが、容量、スケーラビリティ、計算の複雑さの制限により、より大規模で複雑な画像の処理に苦労する可能性があります。

補間だけで連想記憶を実装できますか?

記憶にはモデルがトレーニング データを取得する必要がありますが、補間はトレーニング データを完全に適合させる機能です。したがって、補間だけでは連想記憶を実装できません。補間は、既知のデータ ポイント間の値を近似するのに便利な手法ですが、本格的な連想メモリ システムを実装するには十分ではありません。連想記憶モデルは、入力にノイズが多かったり不完全だったりする場合でも、多くの場合、指定された入力に最も近い保存されたパターンを識別することによって、パターンの関連付けに基づいてパターンを保存および取得するように設計されています。

内挿は既知のデータ ポイント間の値を推定するために使用できますが、本質的にノイズ、不完全な情報、またはパターン認識に対処するように設計されているわけではありません。線形補間や多項式補間などの補間方法は、基礎となる関数が滑らかであるか特定の形式を持つという仮定に依存していますが、現実世界の多くの連想記憶の問題には当てはまらない可能性があります。

連想記憶の代替方法 - 過剰パラメータ化?

過剰パラメータ化とは、機械学習モデルにトレーニング データセットのサイズに比べて多数のパラメーター (重みとバイアス) がある状況を指します。言い換えれば、モデルは、データの根底にあるパターンを説明したりキャプチャしたりするのに必要以上に複雑です。過剰パラメータ化されたモデルがデータを補間できることは以前に観察されました。Radhakrishnanらによる最近の研究。2020 [8] は、オーバーパラメータ化されたオートエンコーダーをトレーニング サンプルの記憶と取得にも使用できることを示しました。仕組みは驚くほどシンプルです。— 例としては次のようなものがあります。

学習したマップを反復するだけで回復できます。

オートエンコーダー!またオーバーパラメータ化されています!これは何?

オートエンコーダは、効率的なデータ表現の教師なし学習に使用される人工ニューラル ネットワークの一種で、多くの場合、次元削減、特徴学習、またはデータ圧縮を目的としています。これは、エンコーダとデコーダという 2 つの主要部分で構成されます。

オートエンコーダのトレーニングの目的は、入力データと、入力をエンコーダ、次にデコーダに渡すことによって生成される再構築データとの間の再構築誤差を最小限に抑えることです。

簡単に言えば、オーバーパラメータ化されたオートエンコーダは、多数のパラメータを持つオートエンコーダです。アディットら。アル。は、オーバーパラメータ化されたオートエンコーダがトレーニング サンプルを固定点またはアクチュエータとして保存することを示しました。ただし、単位マップf(x) = xも学習します。

これは結合性にとってマイナスです。その前提条件は、例の導関数が 1 未満でなければならないことだからです。アル。2020年オーバーパラメータ化されたオートエンコーダは連想メモリを実装するのに十分強力であるという前提に基づいて作業されました。彼らは、オーバーパラメータ化されたオートエンコーダが「アトラクターベースの連想記憶」として使用できることを研究の中で示しました。アトラクターベースのシステムの背後にある中心的な考え方は、保存されたパターンの不完全なバージョンまたはノイズの多いバージョンが与えられたときに、ネットワークがそのパターンを取得できる必要があるということです。入力パターンが手がかりとして機能し、ネットワーク ダイナミクスがシステムを最も近いアトラクターに導き、効果的にノイズを「クリーンアップ」したり、欠落した情報を埋めたりします。簡単に言うと、OPA は連想記憶を実装できます。アトラクターベースの連想記憶であるための数学的条件は次のとおりです。

- 例は固定点である必要があります。

- 例内の導関数は 1 未満である必要があります。

これは本当に起こりますか?

この論文は、さまざまなアーキテクチャや最適化技術にわたるオートエンコーダーにアトラクターが存在する可能性があることを示す広範な経験的証拠を提供します。著者らは、ImageNet-64 データセットからの 500 枚の画像をアトラクターとして保存できるオーバーパラメータ化されたオートエンコーダーの実証に成功しました。彼らは、各例のヤコビ行列の固有値を調べることによって、500 個のトレーニング画像すべてが実際にアトラクターとして保存されていることを確認しました。この研究では、さまざまな形態の汚職下でトレーニング サンプルが回復される割合も分析され、驚くほど高い回復率が明らかになりました。

さらなる実験では、MNIST データセットからの 2,000 枚の画像と CIFAR10 データセットからの 1,000 枚の白黒画像を使用してトレーニングした場合、オートエンコーダーがトレーニング サンプルをアトラクターとして保存できることが示されました。過剰パラメータ化されたオートエンコーダーには偽のアトラクター (トレーニング サンプル以外のアトラクター) が存在する可能性がありますが、研究者らは ImageNet-64 のサンプルでそのような偽のアトラクターを特定できませんでした。

著者らは、さまざまな一般的なアーキテクチャ、最適化方法、および初期化スキームを調査して、アトラクター現象の包括的な分析を実施しました。これらには、さまざまな非線形性、最適化手法、および初期化スキームが含まれます。彼らの発見により、トレーニングが 1,000,000 エポック以内に十分に低い損失に収束するすべてのシナリオでアトラクターが出現することが明らかになりました。重要なのは、この現象は完全に接続されたネットワークに限定されず、畳み込みネットワークやリカレント ネットワークなど、広く使用されているネットワーク アーキテクチャでも観察されたことです。

重要なのは、この現象は完全接続ネットワークに限定されず、畳み込みネットワークやリカレント ネットワークなど、広く使用されているネットワーク アーキテクチャでも観察されたことです。2D アトラクターを視覚化するために、彼らは 6 つのトレーニング サンプルをアトラクターとして保存するようにオートエンコーダーをトレーニングし、トレーニングされたオートエンコーダー マップを 10,000 グリッド ポイントから開始して収束するまで反復することによってアトラクションの領域を視覚化しました。実験のベクトル場は、反復によって与えられる動きの方向を示します。各トレーニング サンプルとそれに対応する魅力の領域は、異なる色で表されます。興味深いことに、この研究では、引力領域を分離するためにオートエンコーダによって学習された計量が、ボロノイ図で示されるユークリッド距離ではないことが明らかになりました。

シーケンスのエンコードは、自動エンコードよりも優れた結果を示します。

目的関数をオートエンコーダからわずかに変更すると、連想メモリが実装されます。研究者らは、十分に小さく安定したしきい値で損失関数を最小化すると、トレーニング シーケンスがネットワークのリミット サイクル (安定した周期的な動作を示すアトラクターの一種) としてエンコードされることを示しました。

エンドノート

結論として、連想記憶は人間の認知の興味深い側面であり、生物システム、ホップフィールド ネットワーク、過剰パラメータ化されたニューラル ネットワークなど、さまざまな状況で研究されています。生物における連想記憶の理解は、ホップフィールド ネットワークなどの計算モデルの開発に影響を与え、人工知能と機械学習の分野を発展させてきました。

Recent research into overparameterized neural networks has discovered the emergence of attractors, a phenomenon related to associative memory, across a range of architectures and optimization techniques. This exciting development not only solidifies the connection between biological and artificial neural systems, but also opens up new opportunities for exploring more efficient and robust models for memory storage and retrieval.

連想記憶の根底にある複雑なメカニズムの解明を続けるにつれて、私たちの発見は人工知能のさらなる革新を促進し、人間の認知能力をシミュレートできる生物学にインスピレーションを得た高度なモデルへの道を開くでしょう。この継続的な探求は、生物学と計算の間の複雑な関係についての理解を深め、最終的には両方の分野に利益をもたらすブレークスルーにつながることを約束します。

Nir N. Shavit の指導と有益な議論に特に感謝します。MIT クラス 6.S978 — 機械学習における組織とシリコン、2023 年春の一部として作成されました。

参考文献

- スミス、J. (2022)。連想記憶とは何ですか? ベリーウェルマインド。https://www.verywellmind.com/what-is-associative-memory-5198601

- ウィルショー、DJ、ビューンマン、OP、ロンゲット=ヒギンズ、HC(1969年)。非ホログラフィック連想記憶。Nature、222 (5197)、960–962。ヤニェス=マルケス、C.、ロペス=ヤニェス、I.、アルダペ=ペレス、M.、カマチョ=ニエト、O.、アルグエルス=クルス、AJ、ヴィルエンダス=レイ、 Y. (2018)。アルファ - ベータ連想記憶の理論的基礎: 10 年間の派生拡張、モデル、およびアプリケーション。神経処理レター、48 (2)、811–847。

- J.J.ホップフィールド(1982年)。新たな集合的計算能力を備えたニューラル ネットワークと物理システム。国立科学アカデミー紀要、79 (8)、2554–2558。

- コスコ、B. (1988)。双方向の連想記憶。IEEE Transactions on Systems、man、および Cybernetics、18(1)、49–60。

- JLマクレランド(2006)。ヘブビアンの学習でどこまで進むことができますか、そしてそれがあなたを迷わせるのはいつですか。脳と認知発達の変化のプロセス: 注意力とパフォーマンス xxi、21、33–69。

- アクリー、デイビッド H.、ジェフリー E. ヒントン、テレンス J. セジノフスキー。「ボルツマンマシンの学習アルゴリズム」認知科学9.1 (1985): 147–169。

- バラバシ、アルバート=ラスロー、レカ・アルバート、ハウン・チョン。「スケールフリーランダムネットワークのための平均場理論」Physica A: 統計力学とその応用272.1–2 (1999): 173–187。

- ラダクリシュナン、アディティアナラヤナン、ミハイル・ベルキン、キャロライン・ウーラー。「過剰パラメータ化されたニューラル ネットワークは連想記憶を実装します。」米国科学アカデミー紀要117.44 (2020): 27162–27170

![とにかく、リンクリストとは何ですか?[パート1]](https://post.nghiatu.com/assets/images/m/max/724/1*Xokk6XOjWyIGCBujkJsCzQ.jpeg)