Plug-ins ChatGPT: carga cognitiva e os dois caminhos de plataforma

Meu último ensaio sobre o potencial dos efeitos de rede na IA generativa (no blog Speedinvest) tentou separar o hype da IA da realidade. Apesar das discussões acaloradas sobre uma “mudança de plataforma”, modelos fundamentais como GPT-4 e Stable Diffusion não tinham as características de uma plataforma. Nem o ChatGPT. No entanto, o lançamento dos plug-ins do ChatGPT muda isso - é, de fato, uma plataforma agora. Mas que tipo de plataforma?

Antes de respondermos a essa pergunta, uma rápida recapitulação ajudaria. Você precisa de quatro componentes para criar uma plataforma — um produto subjacente , uma estrutura de desenvolvimento , correspondência e um benefício econômico . Modelos de linguagem grande (LLMs), como GPT-4, atendem apenas a um dos quatro requisitos - eles fornecem uma estrutura de desenvolvimento para os desenvolvedores criarem novos aplicativos. No entanto, os LLMs não possuem usuários finais e, portanto, não possuem um produto subjacente. Como resultado, eles não podem “combinar” os usuários com os aplicativos certos ou ajudar esses desenvolvedores a melhorar seus negócios.

Da mesma forma, o ChatGPT também não era uma plataforma antes de lançar plugins. Nesse caso, ele possuía usuários e tinha um produto subjacente - o ChatGPT foi lançado como um produto de consumo, mesmo que fosse uma prova de conceito. Mas não tinha uma estrutura de desenvolvimento e, portanto, não poderia “combinar” usuários com aplicativos ou fornecer um benefício econômico. Plugins adicionam uma nova dimensão a isso.

Plug-ins ChatGPT: a plataforma

Plugins introduzem uma estrutura de desenvolvimento para ChatGPT. Mais importante, o ChatGPT também “combina” usuários com aplicativos - os usuários precisam instalar plug-ins relevantes da Loja de plug-ins antes que o ChatGPT possa acessá-los. E, finalmente, o ChatGPT pode fornecer um link de reserva para um plug-in como Expedia ou OpenTable para concluir uma solicitação - um claro benefício econômico para os desenvolvedores de plug-ins. Isso significa que o ChatGPT agora é uma plataforma completa .

Esse não é o fim da história. Como expliquei anteriormente, nem todas as plataformas são criadas iguais . As diferenças entre seus efeitos de rede dependem de alguns fatores:

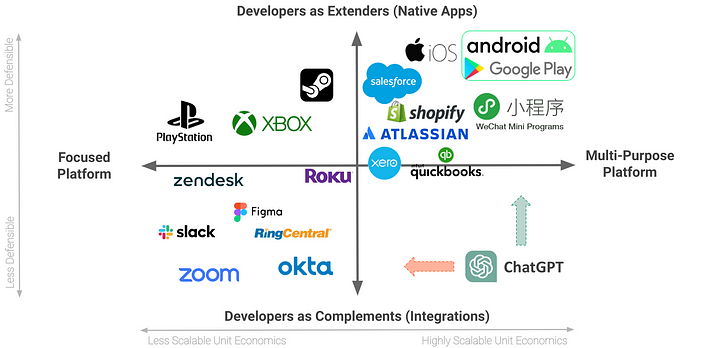

- Plataformas com uma ampla variedade de casos de uso são mais escaláveis (por exemplo, sistemas operacionais de computação móvel como iOS e Android). A partir de hoje, o ChatGPT parece atender a esse critério. Sua variedade estonteante de recursos tem sido amplamente discutida - incluindo geração de código ou conteúdo, ajuda com a lição de casa, reserva de viagens, reservas em restaurantes, sendo uma alternativa de pesquisa, etc.

- As plataformas com aplicativos nativos são mais defensáveis do que aquelas que se integram ou se conectam principalmente com os existentes. A partir de hoje, os plug-ins do ChatGPT são os últimos, ou seja, menos defensáveis - principalmente porque esses desenvolvedores de plug-ins são motivados a se integrar a qualquer plataforma com a qual seus usuários se envolvam (isso pode significar um Google Bard aprimorado, um inimigo como o Bing Chat etc.).

Casos de uso focados + Plugins/Integrações

A primeira possibilidade é que o ChatGPT mova-se para a esquerda nesta matriz, ou seja, torna-se mais focado ao longo do tempo em alguns casos de uso (por exemplo, geração de código/conteúdo, lição de casa , etc.). Consequentemente, os desenvolvedores que possuem aplicativos pré-existentes direcionados a esses casos de uso criam cada vez mais integrações com o ChatGPT, e novos aplicativos nativos não se materializam.

Esta versão do futuro pode soar como ficção científica distópica, mas há um argumento chave a seu favor. Há uma razão pela qual as interfaces de bate-papo e voz têm lutado para decolar na computação até agora - carga cognitiva . Simplificando, pense na quantidade de esforço mental exigido de um usuário para criar um bate-papo ou prompt de voz eficaz e compare isso com o toque de um botão em uma interface gráfica do usuário (GUI).

Para usuários experientes em tecnologia, como desenvolvedores de software, o uso do ChatGPT (ou GitHub Copilot, nesse caso) realmente reduz a carga cognitiva durante a codificação (que por si só requer um esforço mental muito alto). Da mesma forma, o ChatGPT também reduz a carga cognitiva para a redação de conteúdo. No entanto, para o consumidor médio, digitar um prompt eficaz requer uma ordem de magnitude de esforço mental maior em comparação com tocar um botão na GUI de um aplicativo de smartphone ou até mesmo inserir uma frase de pesquisa de 1 a 3 palavras no Google (o comprimento típico de palavras-chave de pesquisa populares ). Se você quiser mais evidências, dê uma olhada na crescente indústria caseira para prompts de IA pré-escritos - não é algo que você precisaria se fosse fácil para as pessoas inventarem.

Obviamente, o ChatGPT é muito mais capaz do que as iterações anteriores de chatbots e assistentes de IA (olá Alexa) que não conseguiram superar o problema de carga cognitiva. Mas só porque pode fazer mais não significa que será usado dessa forma por todos. As limitações são humanas, não relacionadas à tecnologia.

Computação multifuncional + aplicativos nativos

A segunda possibilidade é que o ChatGPT suba nessa matriz, ou seja, mantenha seu status atual de canivete suíço, mesmo com o aumento da adoção. Além disso, os desenvolvedores amadores criam novos casos de uso e criam novos aplicativos nativos na plataforma ChatGPT.

Para seguir esse caminho, o ChatGPT precisaria superar o problema da carga cognitiva — mas como? Isso requer alguma especulação. É perfeitamente possível que o ChatGPT siga um caminho disruptivo , ou seja, melhorando a acessibilidade de sua interface do usuário (no que atualmente apresenta desempenho inferior). Talvez o ChatGPT possa incorporar mais elementos da GUI ou fazer a transição para um paradigma de interface do usuário totalmente diferente com a mesma inteligência que o alimenta. Ou talvez possa avançar até o ponto em que os prompts exijam apenas 1 a 3 palavras (como quantas pessoas usam o Google hoje).

Se o problema da carga cognitiva for resolvido, a única coisa que falta é a engenhosidade do desenvolvedor. Novos modelos de computação e formas de interagir com eles tendem a gerar toda uma nova onda de aplicativos nativos — já vimos essa história acontecer antes com PCs e smartphones. Padrão combinado.

Uma terceira possibilidade é que a plataforma ChatGPT possa acabar no meio por causa dessas forças conflitantes. Se eu tivesse que adivinhar, diria que termina no quadrante inferior esquerdo da estrutura (em algum lugar entre os cenários “esquerda em movimento” e “meio”) - com a IA sendo vista como a linha de montagem, em vez do Ford Modelo T desta era (sendo o ChatGPT uma das primeiras grandes implementações). Claro, isso é apenas mais correspondência de padrões. O tempo vai dizer.

O que você deve fazer a seguir…

1. Pitch me : Não são necessárias introduções quentes

Eu invisto em startups pré-seed/seed-stage como Venture Partner na Speedinvest e também através do Atomico Angel Program. Se sua startup é construída sobre efeitos de rede e sediada na Europa, me apresente aqui .

2. Faça a avaliação dos efeitos de rede

Compare seus efeitos de rede respondendo a um questionário de 1 minuto sobre sua startup ou um possível investimento inicial. Experimente aqui .

3. Inscreva-se no meu curso baseado em coorte

Quer saber mais sobre efeitos de rede? Eu administro um curso de 3 semanas em estilo workshop sobre construção, avaliação, dimensionamento e monetização de efeitos de rede. Registre-se agora para garantir seu lugar ou assista a este curso intensivo gratuito sobre efeitos de rede para ter uma ideia do que esperar.

4. Marque uma consulta

Você tem uma pergunta específica sobre como criar, dimensionar ou monetizar efeitos de rede? Marque uma consulta ou inscreva-se no meu horário de expediente semanal gratuito (eles tendem a esgotar rapidamente).

![O que é uma lista vinculada, afinal? [Parte 1]](https://post.nghiatu.com/assets/images/m/max/724/1*Xokk6XOjWyIGCBujkJsCzQ.jpeg)