İlişkisel Belleğin Uygulanması

Shashata Sawmya ve Harveer Singh tarafından yazıldı.

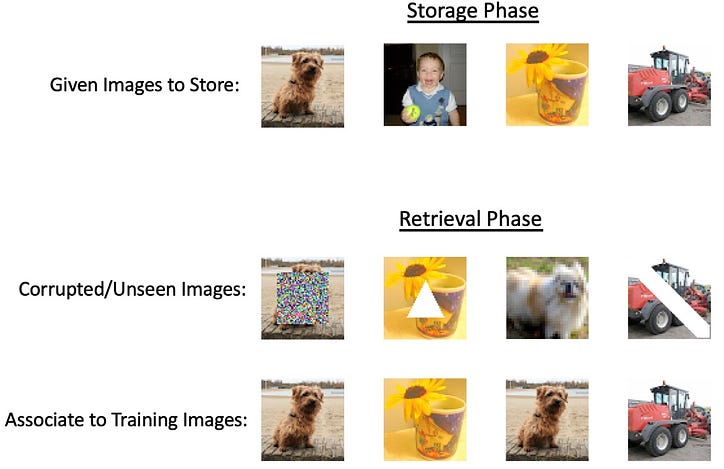

Büyük sinir ağlarının ortaya çıkışı ve mevcut yöntemleri mutlak sınırlarına kadar zorlayan sürekli artan teknolojik gelişmelerle birlikte, her şeyi yapmayı amaçlayan bir tümünü yakalama aracı yaratmaya odaklanıldı. Bununla birlikte, çoğu görev, inanılmaz derecede yoğun derin ağlara ihtiyaç duymaz, ancak yine de temel matematiksel modellerden daha çok yönlü bir şeye ihtiyaç duyar. Derin sinir ağlarının yoğunluğuna ihtiyaç duymayan potansiyel bir görev, çağrışımsal anılar adı verilen bilgi depolama ve geri alma olacaktır. Buradaki fikir, bazı girdiler verildiğinde, bu ikisini bir araya getiren ve onu "bellekte" tutan bir sistemden ilgili çıktıyı alabilmek isteyeceğimizdir. Çağrışımsal bellek adı, beyinlerimizin kavramları birbirine bağlayabilen bir bellek depolama sistemi olduğu şeklindeki psikolojik kavramdan kaynaklanmaktadır. Bir tür ilişkisel bellek, girdi olarak istediğimiz çıktının kısmi bir temsilini verdiğimiz oto-ilişkili bellektir, bu ya ek gürültü içeren çıktı ya da çıktının maskelenmiş kısımları olabilir. Bu tür bir belleğin iş başında olmasına bir örnek, bir akrabanın kısmi bir görüntüsünü görmek ve beyninizin görüntünün geri kalanını zihinsel olarak otomatik olarak doldurabilmesi olabilir. Başka bir tür, çıktıların verilen girdinin farklı kategorilerinde olabileceği, ancak modelin bunları birbirine bağlamayı hatırladığı heteroassociative bellektir. "Köpek" kelimesini duyduğunuzu hayal edin, beyniniz onu otomatik olarak "kedi" veya "tasma" [1] gibi diğer kavramlarla ilişkilendirebilir. Bu tür bir belleğin iş başında olmasına bir örnek, bir akrabanın kısmi bir görüntüsünü görmek ve beyninizin görüntünün geri kalanını zihinsel olarak otomatik olarak doldurabilmesi olabilir. Başka bir tür, çıktıların verilen girdinin farklı kategorilerinde olabileceği, ancak modelin bunları birbirine bağlamayı hatırladığı heteroassociative bellektir. "Köpek" kelimesini duyduğunuzu hayal edin, beyniniz onu otomatik olarak "kedi" veya "tasma" [1] gibi diğer kavramlarla ilişkilendirebilir. Bu tür bir belleğin iş başında olmasına bir örnek, bir akrabanın kısmi bir görüntüsünü görmek ve beyninizin görüntünün geri kalanını zihinsel olarak otomatik olarak doldurabilmesi olabilir. Başka bir tür, çıktıların verilen girdinin farklı kategorilerinde olabileceği, ancak modelin bunları birbirine bağlamayı hatırladığı heteroassociative bellektir. "Köpek" kelimesini duyduğunuzu hayal edin, beyniniz onu otomatik olarak "kedi" veya "tasma" [1] gibi diğer kavramlarla ilişkilendirebilir.

AM (ilişkili bellek) sistemleri zengin bir geçmişe sahiptir, ancak teknik gelişmelere genel bir bakış sağlayabilecek önemli araştırma kilometre taşları vardır:

- Willshaw ağı (Willshaw ve diğerleri, 1969)

- Hopfield ağı (Hopfield, 1982)

Hologramların "bellek benzeri" özelliklerinden esinlenen DJ Willshaw, 1969'da korelografı veya korelogramı ve çağrışımsal belleğe niceliksel bir yaklaşım önerdi.

Yukarıdaki şekil, C üzerinde yeni bir model oluşturmak için A ve B modellerinin evrişimini göstermektedir, daha spesifik olarak A ve B, C üzerinde her iki model hakkında bilgi içeren bir model oluşturmak için içinden bir ışık kaynağının (A'nın arkasında) geçtiği iğne delikleri içerir. iğne delikleri Buradan, aşağıdaki şekil 2'ye bakın, C'ye yansıtılan modelden iğne delikleri oluşturmak ve C'nin arkasından ve B'den yayılan ışığı geçirmek, A'nın iğne deliklerinin bulunduğu yerde tam olarak aynı modeli üretir.

Korelografın inşası sırasında Willshaw, hem A hem de B'de N iğne deliği varsa, C üzerindeki desenin N² boyutunda olacağını fark etti. Bu, N paralel çizginin (A'yı temsil eder) ve N paralel çizginin (B'yi temsil eder) kesişimi olan ilişkisel ağ önerisine yol açtı.

Ağın yapısı, N² uzayındaki her yarım dairenin, hem sol giriş hem de sağ giriş de açıksa, birbirleriyle ilişkilerini temsil edecek şekilde açık olduğunu takip eder. Daha sonra sol taraftaki açık daireleri takip ederek ve N² noktalarından hangisinin açık olduğunu görerek üstten hangi dairelerin ilişkili olduğunu görerek A desenini B'den alabilirsiniz. Bunun sadece bir çift ilişkilendirme ile kolayca çalışacağı açıktır, ancak aynı ağda birden fazla model öğrenmek de mümkündür. Willshaw, ağın teorik maksimum verimliliğinin N² noktalarının %50'sinin açık olduğu zaman olduğunu gösteriyor; bu, "sahte isabet" olasılığını azaltır - A'da orijinal olarak B modeliyle ilişkili olmayan bir nokta olduğunu düşündürür [2 ].

Hopfield Ağı

Doğal olarak çağrışımsal ağı takiben, modern AM tasarımını teşvik eden büyük yenilik, genellikle sinir ağlarının vaftiz babası olarak anılan John Hopfield'ın hopfield ağını önerdiği 1982'de gerçekleşti. Ağ, her bir nöronun ikili durumda (0 veya 1) olduğu ve giriş değeri ile istenen çıkış değeri arasındaki verilen ağırlığın bir ağırlık matrisinde temsil edildiği, tamamen bağlantılı bir yinelemedir.

Tij karşılık gelen ağırlık matrisi ise, ilişkilendirme şu şekilde sağlanır:

Doğruluğu artırmak için akıllıca seçilmiş bir kesme miktarındaki U.

Birden çok ilişkilendirme durumunu depolamak için aşağıdaki algoritma verilir:

i=j için ağırlığın T'de 0 olduğu kısıtlamasını uyguluyoruz. Bu, aşağıdakilerin sözde ortogonalliğine yol açar:

Bu, eğer Vi 1 ise, J için tahmin edilen değerin pozitif ve 0 ise negatif olduğunu gösterir. Bu, U'nun 0 olduğu önceki ilişkilendirme kuralını takip eder.

Bu öğrenme algoritması, esas olarak her model için kararlı durumların ortalamasını alır, ancak bu, belirli bir ağın kaç model hatırlayabileceğini zorlar. Ising modellerinden ve enerji minimizasyonundan ilham alan Hopfield, bu güncelleme mekanizmasının enerji minimizasyonu olarak yorumlanmasını önerir. Bir N düğüm tekrarlayan ağ için, tüm düğümler birbirine bağlıdır, her seferinde bir rastgele düğüm alırız ve bu düğümü güncellemek için ağırlık matrisini kullanırız.

Burada s düğüm numarasıdır ve parantez içindeki değer zaman adımıdır.

Kararlı noktaları incelerken, güncelleme algoritması şu enerji kuralıyla tanımlanır:

Bu, Vi'deki herhangi bir değişikliğin, Vi'deki değişiklik (+ veya -) matris çarpımından elde edilen çıktının işaretiyle eşleştiği sürece ağın enerjisini azalttığını gösterir.

Düğümler, verilen enerji kuralına ve eşik değerine göre eşzamansız ve rastgele olarak güncellenir. Güncelleme kuralı yalnızca her zaman adımında enerjiyi azaltırsa bir nöronu değiştirdiğinden, kararlı bir enerji durumuna ulaşılması garanti edilir. Kaç tane kararlı durumun var olabileceğini belirlerken, modeldeki N nöron için yaklaşık .15N durumunun var olduğu gösterildi, kesin bir o(N) ölçekleme [3]. Bu tür bir ağın yapısının kendi kendine ilişkilendirmeli görevlerde başarılı olmaya elverişli olduğunu belirtmekte fayda var, ancak "vektör-matris-vektör" kodlamaları gibi hetero-ilişkisel belleği de uygulayabilen varyasyonlar var [4].

Biyolojik teoriler

Yukarıda belirtilen tüm modelleri yönlendiren temel fikir, bir nöronun eşleştirilen modeldeki ile eşleşmesi durumunda bir bağlantıyı desteklemektir. Bu öğrenme tarzı, iki nöron birlikte ateşlenirse sinapslarda bir bağlantıyı destekleyen "Hebbian öğrenme" olarak bilinir. Beyinde hafıza oluşumu hala bilinmeyen bir fenomen olmasına rağmen, laboratuvarda bu "birlikte ateşle birlikte tel" fikrinin biyolojik olarak doğru olduğu gösterilmiştir [5].

In-silico ilişkisel belleği uygulama

İlişkisel bellek, farklı veri parçaları arasındaki ilişkilere veya ilişkilere dayalı olarak bilgilerin depolanmasına ve alınmasına izin veren bir bellek türüdür. Böyle bir sistem için hesaplamalı modeller geliştirmek, nörobilim ve yapay zekanın kesiştiği noktada köklü bir sorundur. Hopfield ağları gibi iyi çalışılmış yöntemler yalnızca ikili kalıpları depolayabilir; ancak karmaşık veriler (resimler ve metinler gibi) sorunu çözmek için karmaşık sistemler gerektirir.

Enerji temelli yöntemler çağrışımsal bellek için iyi hesaplamalı modeller midir?

Hemen hemen tüm enerji tabanlı çağrışımsal bellek modelleri, kalıpları bir enerji fonksiyonunun yerel minimumlarında saklar. Bu modellerin arkasındaki ana fikir, depolanan modellerin düşük enerjili kararlı durumlara karşılık geldiği bir enerji manzarası tanımlamaktır. Enerji fonksiyonu, her biri depolanmış bir modeli temsil eden birden çok yerel minimuma sahip olacak şekilde tasarlanmıştır. Sistem bir girdi aldığında, enerji fonksiyonunu en aza indirmek için durumunu yinelemeli olarak günceller ve sonunda girdiye en yakın yerel minimum olan en yakın saklanan modele yakınsar. Bazı enerji tabanlı modeller -

Hopfield Ağları [2]: Hopfield ağlarındaki enerji fonksiyonu, ağın durumunun ikinci dereceden bir fonksiyonu olarak tanımlanır. Depolanan her model, bu enerji fonksiyonunun yerel bir minimumuna karşılık gelir. Ağ dinamikleri, sistemin bu yerel minimumlardan birine yakınsamasını ve ilişkili modeli etkili bir şekilde almasını sağlar.

Boltzmann Makineleri [6]: Boltzmann makinelerinde enerji fonksiyonu, düğümlerin durumları ve aralarındaki bağlantıların ağırlıkları cinsinden tanımlanır. Öğrenme süreci, depolanan modellere karşılık gelen yerel minimumlara sahip bir enerji manzarası oluşturmak için ağırlıkları ayarlar. Sistem daha sonra enerji ortamını keşfetmek ve yerel bir minimuma yerleşmek için stokastik dinamikleri kullanır ve karşılık gelen modeli alır.

Ortalama alan teorisine dayalı yaklaşımlar [7]: Bu yaklaşımlar aynı zamanda bir enerji fonksiyonunun yerel minimumlarındaki kalıpları da saklar. Karmaşık bir sistemin dinamiklerini ortalama alan teorisiyle yaklaştırarak, öğrenme ve geri getirme süreçleri daha verimli bir şekilde analiz edilebilir ve optimize edilebilir.

Bu geleneksel modeller, küçük ölçekli görüntü verilerini işleyebilir, ancak kapasite, ölçeklenebilirlik ve hesaplama karmaşıklığındaki sınırlamaları nedeniyle daha büyük ve daha karmaşık görüntülerle mücadele edebilir.

Enterpolasyon tek başına çağrışımsal hafızayı uygulayabilir mi?

Ezberleme, modelin eğitim verilerini almasını gerektirirken enterpolasyon, eğitim verilerini mükemmel bir şekilde sığdırma yeteneğidir. Dolayısıyla, enterpolasyon tek başına ilişkisel belleği uygulayamaz. Enterpolasyon, bilinen veri noktaları arasındaki değerleri tahmin etmek için yararlı bir teknik olabilir, ancak tam teşekküllü bir çağrışımsal bellek sistemi uygulamak için yeterli değildir. İlişkisel bellek modelleri, girdi gürültülü veya eksik olsa bile, genellikle belirli bir girdiye en yakın saklanan modeli tanımlayarak, ilişkilerine göre kalıpları depolamak ve almak için tasarlanmıştır.

Enterpolasyon, bilinen veri noktaları arasındaki değerleri tahmin etmek için kullanılabilse de doğası gereği gürültü, eksik bilgi veya örüntü tanıma ile başa çıkmak için tasarlanmamıştır. Doğrusal veya polinom enterpolasyonu gibi enterpolasyon yöntemleri, temel işlevin pürüzsüz olduğu veya belirli bir forma sahip olduğu varsayımına dayanır; bu, gerçek dünyadaki pek çok çağrışımsal bellek problemi için doğru olmayabilir.

İlişkisel bellek için alternatif bir yöntem — aşırı parametreleştirme?

Aşırı parametreleştirme, bir makine öğrenimi modelinin, eğitim veri kümesinin boyutuna kıyasla çok sayıda parametreye (ağırlıklar ve sapmalar) sahip olduğu bir durumu ifade eder. Başka bir deyişle, model, verilerdeki temel kalıpları açıklamak veya yakalamak için gerekenden daha karmaşıktır. Aşırı parametreli modellerin verileri enterpolasyon yapabileceği daha önce gözlemlenmişti; Radhakrishnan ve diğerleri tarafından yakın zamanda yapılan bir çalışma. 2020 [8], aşırı parametreli otomatik kodlayıcıların eğitim örneklerini ezberlemek ve almak için de kullanılabileceğini gösterdi. Mekanizma oldukça basittir; — örnekler olabilir

öğrenilen haritayı yineleyerek kolayca kurtarıldı.

Otomatik kodlayıcılar! Ayrıca aşırı parametrelenmiş! Bunlar ne?

Otomatik kodlayıcı, genellikle boyut azaltma, özellik öğrenme veya veri sıkıştırma amacıyla verimli veri temsillerinin denetimsiz öğrenimi için kullanılan bir tür yapay sinir ağıdır. Kodlayıcı ve kod çözücü olmak üzere iki ana bölümden oluşur.

Bir otomatik kodlayıcının eğitim amacı, girişin kodlayıcıdan ve ardından kod çözücüden geçirilmesiyle oluşturulan, giriş verileri ile yeniden oluşturulmuş veriler arasındaki yeniden yapılandırma hatasını en aza indirmektir.

Basitçe söylemek gerekirse, aşırı parametreli bir otomatik kodlayıcı, çok sayıda parametreye sahip bir otomatik kodlayıcıdır. Adit et. al. aşırı parametreli otomatik kodlayıcıların eğitim örneklerini sabit noktalar veya aktüatörler olarak sakladığını gösterdi. Ancak f(x) = x özdeşlik haritasını da öğrenir.

Bu çağrışımsallık için bir aleyhtedir, çünkü bunun bir önkoşulu, örneklerdeki türevin 1'den küçük olması gerektiğidir. Adit et. al. 2020aşırı parametreli otomatik kodlayıcıların ilişkisel belleği uygulamak için yeterince güçlü olduğu öncülünde çalıştı. Çalışmalarında, aşırı parametreli otokodlayıcıların "Çekici tabanlı İlişkisel Bellek" olarak kullanılabileceğini gösterdiler. Çekici tabanlı sistemlerin arkasındaki temel fikir, ağın, bu modelin eksik veya gürültülü bir versiyonu verildiğinde, depolanan bir modeli geri alabilmesidir. Giriş modeli bir ipucu görevi görür ve ağ dinamikleri, gürültüyü etkili bir şekilde "temizleyerek" veya eksik bilgileri doldurarak sistemi en yakın çekiciye doğru yönlendirir - basitçe OPA'nın ilişkisel belleği uygulayabilmesi. Çekici temelli çağrışımsal bellek olmanın matematiksel koşulları şunlardır:

- Örnekler sabit noktalar olmalıdır.

- Örneklerdeki türevler 1'den küçük olmalıdır.

Bu gerçekten oluyor mu?

Makale, çekicilerin çeşitli mimariler ve optimizasyon tekniklerinde otomatik kodlayıcılarda bulunabileceğine dair kapsamlı ampirik kanıtlar sunmaktadır. Yazarlar, ImageNet-64 veri setinden 500 görüntüyü çekici olarak depolayabilen aşırı parametreli bir otomatik kodlayıcıyı başarıyla gösterdiler. Her örnek için Jacobian matrisinin özdeğerlerini inceleyerek 500 eğitim görüntüsünün hepsinin çekici olarak saklandığını doğruladılar. Çalışma aynı zamanda eğitim örneklerinin farklı yolsuzluk biçimleri altında kurtarılma oranını da analiz ederek etkileyici derecede yüksek bir kurtarma oranı ortaya koydu.

Diğer deneyler, otomatik kodlayıcıların, MNIST veri kümesinden 2.000 görüntü ve CIFAR10 veri kümesinden 1.000 siyah-beyaz görüntü ile eğitildiğinde, eğitim örneklerini çekiciler olarak da depolayabildiğini gösterdi. Sahte çekiciler (eğitim örnekleri dışındaki çekiciler) aşırı parametreli otokodlayıcılarda potansiyel olarak mevcut olabilse de, araştırmacılar ImageNet-64 örneğinde bu tür sahte çekicileri tanımlayamadılar.

Yazarlar, çeşitli ortak mimarileri, optimizasyon yöntemlerini ve başlatma şemalarını inceleyerek çekici fenomeninin kapsamlı bir analizini gerçekleştirdi. Bunlar, bir dizi doğrusal olmayan durumu, optimizasyon yöntemlerini ve başlatma şemalarını içeriyordu. Bulguları, eğitimin 1.000.000 dönem içinde yeterince düşük bir kayba yaklaştığı her senaryoda çekicilerin ortaya çıktığını ortaya koydu. Anlamlı bir şekilde, bu fenomen tamamen bağlı ağlarla sınırlı değildi, evrişimli ve tekrarlayan ağlar gibi yaygın olarak kullanılan ağ mimarilerinde de gözlemlendi.

Evrişimli ve tekrarlayan ağlar gibi yaygın olarak kullanılan ağ mimarilerinde de gözlemlendiği gibi, bu olgu anlamlı bir şekilde tamamen bağlı ağlarla sınırlı değildi. 2B çekicileri görselleştirmek için, altı eğitim örneğini çekici olarak depolaması için bir otomatik kodlayıcıyı eğittiler ve 10.000 ızgara noktasından yakınsamaya kadar eğitimli otomatik kodlayıcı haritasını yineleyerek çekim havzalarını görselleştirdiler. Deneydeki vektör alanı yinelemeyle verilen hareket yönünü gösterir. Her eğitim örneği ve buna karşılık gelen çekim alanı farklı renklerle temsil edilir. İlginç bir şekilde, çalışma, otomatik kodlayıcı tarafından çekim havzalarını ayırmak için öğrenilen ölçünün, bir Voronoi diyagramı ile gösterilecek olan Öklid mesafesi olmadığını ortaya çıkardı.

Dizi kodlaması, otomatik kodlamadan daha iyi sonuçlar gösterir.

Amaç işlevinin otomatik kodlayıcılardan biraz değiştirilmesi, ilişkisel anıların uygulanmasıyla sonuçlanır. Araştırmacılar, yeterince küçük ve kararlı bir eşik için kayıp fonksiyonunu en aza indirmenin, eğitim dizilerini ağın sınır döngüleri (sabit, periyodik davranış sergileyen bir çekici türü) olarak kodladığını gösterdi.

Son Not

Sonuç olarak, çağrışımsal hafıza, biyolojik sistemler, Hopfield ağları ve aşırı parametreli sinir ağları dahil olmak üzere çeşitli bağlamlarda incelenen insan bilişinin büyüleyici bir yönüdür. Canlı organizmalardaki çağrışımsal hafıza anlayışımız, sırasıyla yapay zeka ve makine öğrenimi alanlarını geliştiren Hopfield ağları gibi hesaplama modellerinin geliştirilmesine ilham verdi.

Aşırı parametreli sinir ağlarına yönelik son araştırmalar, bir dizi mimari ve optimizasyon tekniğinde çağrışımsal bellekle ilgili bir fenomen olan çekicilerin ortaya çıktığını keşfetti. Bu heyecan verici gelişme, yalnızca biyolojik ve yapay sinir sistemleri arasındaki bağlantıyı sağlamlaştırmakla kalmıyor, aynı zamanda bellek depolama ve geri alma için daha verimli ve sağlam modelleri keşfetmek için yeni fırsatlar sunuyor.

Çağrışımsal belleğin altında yatan karmaşık mekanizmaları ortaya çıkarmaya devam ettikçe, bulgularımız yapay zekada daha fazla inovasyonu ateşleyecek ve insanın bilişsel yeteneklerini simüle edebilen gelişmiş, biyolojik olarak ilham alan modellerin önünü açacaktır. Bu devam eden keşif, biyoloji ve hesaplama arasındaki karmaşık ilişki hakkındaki anlayışımızı geliştirmeyi vaat ediyor ve sonuçta her iki alana da fayda sağlayabilecek buluşlara yol açıyor.

Rehberliği ve yararlı tartışması için Nir N. Shavit'e özel teşekkürler. MIT sınıfı 6.S978 — Machine Learning'de Tissue vs. Silicon, İlkbahar 2023'ün bir parçası olarak oluşturuldu.

Referanslar

- Smith, J. (2022). İlişkisel Bellek Nedir? Çok iyi Zihin.https://www.verywellmind.com/what-is-associative-memory-5198601

- Willshaw, DJ, Buneman, OP ve Longuet-Higgins, HC (1969). Holografik olmayan çağrışımsal bellek. Nature , 222 (5197), 960–962.Yáñez-Márquez, C., López-Yáñez, I., Aldape-Pérez, M., Camacho-Nieto, O., Argüelles-Cruz, AJ ve Villuendas-Rey, Y. (2018). Alfa-Beta İlişkili Anılar için Teorik Temeller: 10 Yıllık Türetilmiş Uzantılar, Modeller ve Uygulamalar. Nöral İşlem Mektupları , 48 (2), 811–847.

- Hopfield, JJ (1982). Ortaya çıkan toplu hesaplama yeteneklerine sahip sinir ağları ve fiziksel sistemler. Ulusal Bilimler Akademisi Tutanakları , 79 (8), 2554–2558.

- Kosko, B. (1988). Çift yönlü çağrışımsal anılar. Sistemlerde IEEE İşlemleri, insan ve Sibernetik, 18(1), 49–60.

- McClelland, JL (2006). Hebbian öğrenimi ile ne kadar ileri gidebilirsiniz ve bu sizi ne zaman yoldan çıkarır? Beyin ve bilişsel gelişimdeki değişim süreçleri: Dikkat ve performans xxi, 21, 33–69.

- Ackley, David H., Geoffrey E. Hinton ve Terrence J. Sejnowski. "Boltzmann makineleri için bir öğrenme algoritması." Bilişsel bilim 9.1 (1985): 147–169.

- Barabási, Albert-László, Réka Albert ve Hawoong Jeong. "Ölçeksiz rastgele ağlar için ortalama alan teorisi." Fizik A: İstatistiksel Mekanik ve Uygulamaları 272.1–2 (1999): 173–187.

- Radhakrishnan, Adityanarayanan, Mikhail Belkin ve Caroline Uhler. "Aşırı parametreli nöral ağlar, ilişkisel bellek uygular." Ulusal Bilimler Akademisi Tutanakları 117.44 (2020): 27162–27170

![Bağlantılı Liste Nedir? [Bölüm 1]](https://post.nghiatu.com/assets/images/m/max/724/1*Xokk6XOjWyIGCBujkJsCzQ.jpeg)