Co to jest NPU i dlaczego Big Tech nagle wpadł w obsesję?

Jest procesor. Jest procesor graficzny . W zeszłym roku każda firma technologiczna mówiła o „NPU”. Jeśli nie znasz dwóch pierwszych, prawdopodobnie jesteś zaskoczony trzecim i tym, dlaczego cała branża technologiczna wychwala zalety jednostki przetwarzania neuronowego. Jak można się domyślić, wszystko to spowodowane trwającym cyklem szumu wokół sztucznej inteligencji. A jednak firmy technologiczne dość słabo radzą sobie z wyjaśnianiem, co robią te jednostki NPU i dlaczego powinno Cię to obchodzić.

powiązana zawartość

Każdy chce kawałek ciasta AI. Google powiedział „AI” ponad 120 razy podczas tegomiesięcznej konferencji programistów I/O , gdzie możliwości nowych aplikacji i asystentów AI praktycznie zachwyciły swoich gospodarzy. Podczas niedawnej konferencji poświęconej kompilacji firma Microsoft skupiała się na nowych komputerach Copilot+ opartych na architekturze ARM, wyposażonych w procesory Qualcomm Snapdragon X Elite i X Plus. Każdy procesor nadal będzie oferował NPU z 45 TOPS. Co to znaczy? Cóż, nowe komputery powinny obsługiwać sztuczną inteligencję na urządzeniu. Jednak jeśli się nad tym zastanowić, dokładnie to obiecali Microsoft i Intel pod koniec zeszłego roku, wydając tak zwany „ komputer AI ”.

powiązana zawartość

- Wyłączony

- język angielski

Jeśli kupiłeś w tym roku nowy laptop z procesorem Intel Core Ultra, obiecując sztuczną inteligencję w urządzeniu, prawdopodobnie nie będziesz zadowolony, że zostaniesz w tyle. Microsoft powiedział Gizmodo, że tylko komputery Copilot+ będą miały dostęp do funkcji opartych na sztucznej inteligencji, takich jak Recall, „ze względu na chipy, które je obsługują”.

Pojawiły się jednak pewne spory, gdy znany autor przecieków Albacore stwierdził, że może uruchomić Recall na innym komputerze PC opartym na ARM64 bez polegania na NPU. Nowe laptopy nie są jeszcze dostępne, ale musimy poczekać i zobaczyć, jak duży nacisk nowe funkcje AI wywierają na procesory neuronowe.

Ale jeśli naprawdę ciekawi Cię, co się dzieje z jednostkami NPU i dlaczego wszyscy, od Apple, przez Intel, po start-upy małych komputerów PC, o nich mówią, przygotowaliśmy wyjaśnienie, które pomoże Ci przyspieszyć.

Wyjaśnienie NPU i „TOPS”

Najpierw więc powinniśmy zaoferować osobom działającym w tle szybki przegląd możliwości obliczeniowych Twojego zwykłego komputera. Procesor, czyli „jednostka centralna”, jest zasadniczo „mózgiem” komputera przetwarzającym większość zadań użytkownika. Procesor graficzny, czyli „jednostka przetwarzania grafiki”, jest bardziej wyspecjalizowany do obsługi zadań wymagających dużych ilości danych, takich jak renderowanie obiektu 3D lub granie w grę wideo. Procesory graficzne mogą być oddzielną jednostką wewnątrz komputera lub mogą być umieszczone w samym procesorze.

W ten sposób NPU jest bliżej GPU pod względem wyspecjalizowanej natury, ale przynajmniej na razie nie znajdziesz osobnego procesora neuronowego poza jednostką centralną lub procesorem graficznym. Jest to typ procesora zaprojektowany do obsługi obliczeń matematycznych specyficznych dla algorytmów uczenia maszynowego. Zadania te są przetwarzane „równolegle”, co oznacza, że żądania zostaną podzielone na mniejsze zadania, a następnie przetworzone jednocześnie. Został specjalnie zaprojektowany, aby sprostać intensywnym wymaganiom sieci neuronowych bez wykorzystania procesorów innych systemów.

Standardem oceny prędkości NPU jest TOPS, czyli „biliony operacji na sekundę”. Obecnie jest to jedyny sposób, w jaki duże firmy technologiczne porównują ze sobą swoje możliwości przetwarzania neuronowego. Jest to także niezwykle redukcyjny sposób porównywania szybkości przetwarzania. Procesory i procesory graficzne oferują wiele różnych punktów porównawczych, od liczby i typów rdzeni po ogólne prędkości zegara lub teraflopy, ale nawet to nie pozwala na poznanie komplikacji związanych z architekturą chipów. Qualcomm wyjaśnia , że TOPS to po prostu szybkie i brudne równanie matematyczne łączące szybkość i dokładność procesorów neuronowych.

Być może pewnego dnia przyjrzymy się procesorom NPU z taką samą szczegółowością jak procesory czy procesory graficzne, ale może to nastąpić dopiero po zakończeniu obecnego cyklu szumu dotyczącego sztucznej inteligencji. Nawet wtedy żaden z tych podziałów procesorów nie jest ustalony. Istnieje również pomysł procesorów GPNPU, które są w zasadzie połączeniem możliwości procesora graficznego i NPU. Wkrótce będziemy musieli podzielić możliwości mniejszych komputerów obsługujących sztuczną inteligencję na większe, które będą w stanie obsłużyć setki, a nawet tysiące TOPS.

NPU istnieją już od kilku lat zarówno w telefonach, jak i komputerach PC

Telefony również korzystały z jednostek NPU na długo przed tym, zanim większość ludzi i firm się tym przejęła. Google wspominało o NPU i możliwościach AI już w Pixelu 2 . Chińskie Huawei i Asus zadebiutowały NPU w telefonach takich jak Mate 10 z 2017 roku i Zenphone 5 z 2018 roku . Obie firmy próbowały wówczas rozszerzyć możliwości sztucznej inteligencji na oba urządzenia, chociaż klienci i recenzenci byli znacznie bardziej sceptyczni co do ich możliwości niż obecnie.

Rzeczywiście, dzisiejsze jednostki NPU są znacznie potężniejsze niż sześć czy osiem lat temu, ale gdybyś nie zwrócił na to uwagi, pojemność neuronowa większości tych urządzeń by ci umknęła.

Chipy komputerowe były wyposażone w procesory neuronowe już od lat przed 2023 rokiem. Na przykład procesory Apple z serii M, zastrzeżone przez firmę chipy oparte na ARC, obsługiwały już możliwości neuronowe w 2020 roku. Układ M1 miał 11 TOPS, a M2 i M3 15,8 i 19 TOPS, odpowiednio. Dopiero dzięki chipowi M4 w nowym iPadzie Pro 2024 Apple zdecydował, że musi pochwalić się szybkością 38 TOPS swojego najnowszego silnika neuronowego. A które aplikacje AI na iPadzie Pro naprawdę korzystają z tej nowej możliwości? Niewiele, szczerze mówiąc. Być może za kilka tygodni na WWDC 2024 zobaczymy więcej , ale będziemy musieli poczekać i zobaczyć .

Obecna obsesja na punkcie NPU to po części sprzęt, a po części szum

Ideą NPU jest to, że powinna być w stanie zdjąć ciężar uruchamiania sztucznej inteligencji na urządzeniu z procesora lub karty graficznej, umożliwiając użytkownikom uruchamianie programów AI, niezależnie od tego, czy są to generatory grafiki AI, czy chatboty, bez spowalniania ich komputerów. Problem w tym, że wszyscy wciąż szukamy prawdziwego programu sztucznej inteligencji, który mógłby wykorzystać zwiększone możliwości sztucznej inteligencji.

W ciągu ostatniego roku Gizmodo prowadził rozmowy z głównymi producentami chipów i wciąż słyszymy, że producenci sprzętu uważają, że choć raz przewyższyli popyt na oprogramowanie. Przez dłuższy czas było odwrotnie. Twórcy oprogramowania przesuwaliby granice tego, co jest dostępne na sprzęcie konsumenckim, zmuszając producentów chipów do nadrabiania zaległości.

Jednak od 2023 r. widzieliśmy tylko kilka marginalnych aplikacji AI, które można uruchomić na urządzeniu. Większość wersji demonstracyjnych możliwości sztucznej inteligencji chipów Qualcomma lub Intela zazwyczaj obejmuje uruchomienie funkcji rozmycia tła Zoom. Ostatnio widzieliśmy, jak firmy porównywały swoje procesory NPU z modelem generatora muzyki AI Riffusion w istniejących aplikacjach, takich jak Audacity lub z napisami na żywo w OBS Studio. Jasne, możesz znaleźć aplikacje obsługujące chatboty, które mogą działać na urządzeniu, ale mniej wydajny i mniej dopracowany LLM nie sprawia wrażenia gigantycznej aplikacji-zabójcy, która sprawi, że wszyscy wybiegną, by kupić najnowszy nowy smartfon lub „komputer ze sztuczną inteligencją”. ”

Zamiast tego ograniczamy się do stosunkowo prostych aplikacji z Gemini Nano na telefonach Pixel , takich jak podsumowania tekstowe i audio . Najmniejsza wersja sztucznej inteligencji Google trafi na Pixel 8 i Pixel 8a . Funkcje AI Samsunga, które kiedyś były dostępne wyłącznie w Galaxy S24, trafiły już do starszych telefonów i wkrótce powinny trafić do firmowych urządzeń ubieralnych . Nie sprawdziliśmy szybkości działania sztucznej inteligencji na starszych urządzeniach, ale wskazuje to na to, że starsze urządzenia już od 2021 r. miały już dużą zdolność przetwarzania neuronowego.

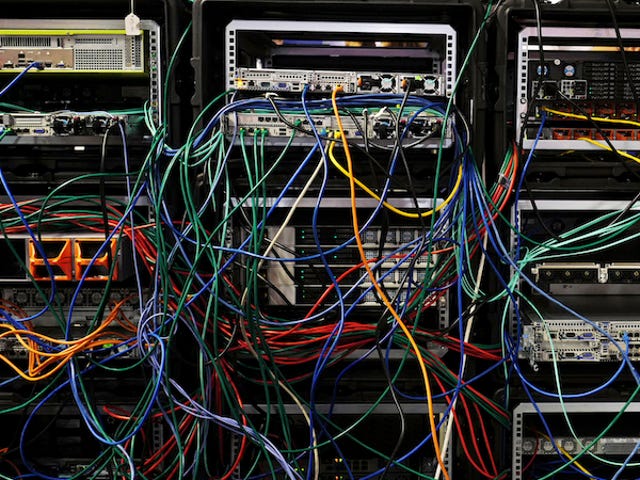

Sztuczną inteligencję na urządzeniach nadal utrudnia brak mocy obliczeniowej w przypadku produktów końcowych dla konsumentów. Microsoft, OpenAi i Google muszą obsługiwać główne centra danych wyposażone w setki zaawansowanych procesorów graficznych AI firmy Nvidia , takich jak H100 ( według doniesień Microsoft i inne firmy pracują nad własnymi chipami AI ), aby przetwarzać niektóre z bardziej zaawansowanych LLM lub chatbotów z modelami jak Gemini Advanced lub GPT 4o . Nie jest to tanie rozwiązanie, jeśli chodzi o pieniądze lub zasoby, takie jak energia i woda , ale dlatego tak wielu bardziej zaawansowanych konsumentów sztucznej inteligencji może za to zapłacić, działa w chmurze. Uruchomienie sztucznej inteligencji na urządzeniu przynosi korzyści użytkownikom i środowisku. Jeśli firmy uznają, że konsumenci wymagają najnowszych i najlepszych modeli sztucznej inteligencji, oprogramowanie będzie w dalszym ciągu wyprzedzać możliwości dostępne na urządzeniach końcowych konsumentów.